Stable Diffusion本地环境搭建

按装部署

最近看Stable Diffusion开源了,据说比Disco Diffusion更快,于是从git上拉取了项目尝试本地部署。

这里是官网介绍:https://stability.ai/blog/stable-diffusion-public-release

首先把代码拉下来,

https://github.com/CompVis/stable-diffusion.git |

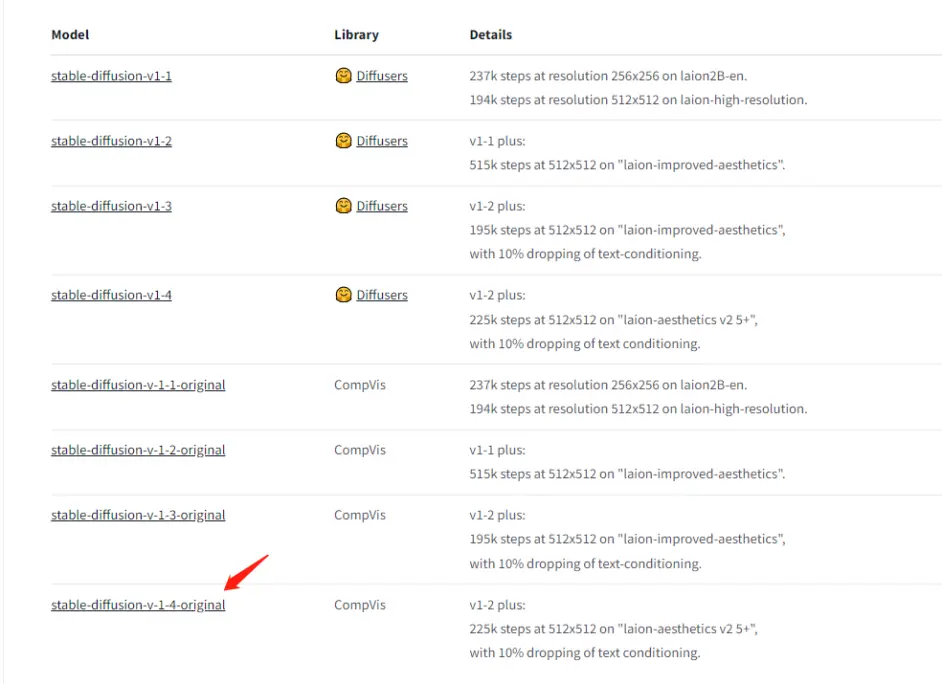

然后下载模型,模型有几种,需要去 https://huggingface.co/CompVis 下载,这里还需要注册账号,先注册下

如果我们用sd-v1-4.ckpt这个模型,就在该网页里点击stable-diffusion-v-1-4-original那一项:

跳转过去,找到Download the weights下面的sd-v1-4.ckpt即可点击下载,通常几G,下载时间较长。

其次就是按照readme的文档,link一下模型:

mkdir -p models/ldm/stable-diffusion-v1/ |

然后运行测试:

python scripts/txt2img.py --prompt "a photograph of an astronaut riding a horse" --plms |

找不到taming 的问题

运行例子过程中就有这个问题:

(stable_diffusion_env) fcbai@fcbai-NUC11PAHi7:~/workspace/github/stable-diffusion$ python scripts/txt2img.py --prompt "a photograph of an astronaut riding a horse" --plms |

我开始以为是缺失taming package,所以安装了transformers的taming:

pip install taming-transformers |

后来发现不对:

Traceback (most recent call last): |

再去看issue,发现这个是个bug,可以看:https://github.com/CompVis/taming-transformers/issues/176

解决方法就是:

git clone https://github.com/CompVis/taming-transformers |

VectorQuantizer2是新的测试功能,还没有出现在正式库中,最后我的所有freeze内容是:

appdirs==1.4.4 |

其中关于torch需要这样安装:

pip3 install --pre torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/cu117 |

考虑到测试的完整性,我使用了nightly版本。

扫码手机观看或分享: