大模型这门生意,你真的摸透了吗 ?

百花齐放的大模型

围绕大模型的生意,百花齐放,不同企业在不同维度上各自做着不同的事,但是都围绕着大模型讲故事。

同时,对于存在大模型需求的企业来说,同时也在观望大模型可能带来的价值,但是又摸不透大模型的投入产出比,始终徘徊在是否采纳的门槛上。

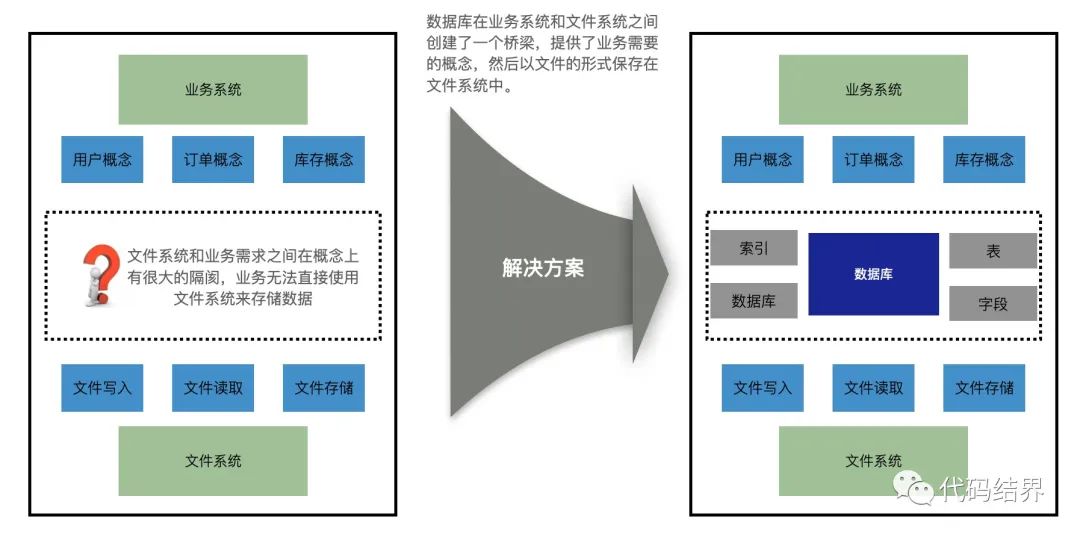

我一直坚持认为,大模型只是数据的另一种消费形式,除了大模型之外,报表工具,数据服务,以及大屏业务都属于数据消费的形态,只是大模型目前被大概论证,已经可以投入生产了,于是数据多了一种消费方式:把数据注入到大模型中,让大模型可以在不同的业务场景下,输出符合条件的内容。

所以对于大多数企业来说,要做好大模型业务,还是先踏踏实实地把数据平台搞好,当一个企业没有较为完备的数据平台去存储,加工,治理企业数据的时候,是没有办法完成一个大模型对接业务的完整生命周期的,最多只能在一些小的业务场景下去完成部分POC测试。

同时从模型视角来看,存在无数个大模型提供商可以供大家选择,开源的,服务化的,国内,国外的,大厂的,创业公司的,玲琅满目,但是大模型这项业务,围绕这个业务的生意,应该怎么做呢?

大模型的那些生意

好卖的东西,大概率不赚钱,而赚钱的生意,大概率不好卖,原因在于好卖的东西,一定是刚好打中对方的喜好点,也正因为如此,这个喜好点更大可能就他有,于是这门生意会变成一项定制化的工作,最后演变成单纯人力成本且不可复制。

而赚钱的生意,意味着收入和投入的关系,是指数的形态,而非线形增长,要达到这个效果,自然得是标品,既然是标品,那自然你能做,我也能做,就不那么好卖。

于是用好卖的东西亏本投入,去拉动赚钱的东西,才是正常的流程,对于大模型业务来说,这个逻辑依旧适用。

围绕大模型来看,目前主要存在的生意基本上这几类:

- 硬件开发:围绕AI 芯片开发的企业,以及做GPU的企业,属于纯硬件厂商,这里特别强调下AI芯片和GPU不是一码事。

- 基础设施:做大模型本身的企业,这类企业需要采购大量的大模型相关的硬件,然后训练自己的大模型,卖点就在大模型的涌现能力,拼的就是模型能力。

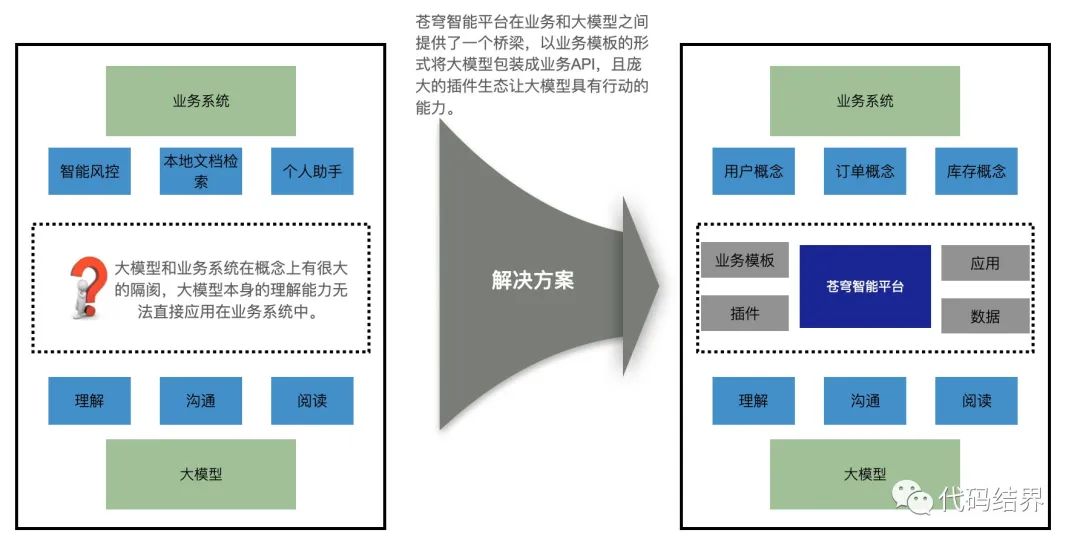

- 模型PAAS:这类企业不做大模型,但是会提供一个运行模型所需要的PAAS平台,直观上感觉,很多人会觉得做大模型训练的企业,就应该自己有这样一个平台,但是并不是,比如大家去BAT大模型平台,使用模型服务的时候,能够看到这些平台卖的模型,除了自家的模型外,还同时支持售卖其余厂商的模型,这背后核心的原因是在于驾驭大模型本身,训练一个大模型需要的投入并不低,做模型训练的团队需要更多精力关注在模型本身上,至于模型商业化,可以交由其他合作伙伴进行,其次大部分大模型企业,所有的技术构建都是以AI为主,并不能快速切到构建一个PAAS平台上来,因此合作是最佳的方式。

- 模型应用:围绕一个模型,构建具体的业务,这个业务是明确,且清晰的,在这个维度上,我认为凡是做AI+的,也就是拿着模型去重做业务的,都很难做起来,而+AI的,也就是本身存在了业务,只是把模型融合进去,一定会做的很不错。

其实仔细看看这里面的几类生意就能发现,不同位置有明显的侧重点,但是一定会和周边衔接的地方存在竞争,比如做大模型的企业,一旦大模型训练这件事趋于稳定,且投入过程标准化后,必然会走向自己做PAAS平台,甚至会做自己的芯片,这就是构建商业版图,无他,我都要而已。

而一个企业能在这场战斗中活下来的前提条件,就是在别人开始进行版图辐射之前,巩固了自己的堡垒,且可以辐射出去。

那么不同维度的核心竞争力在哪?

- 硬件开发:自然是芯片设计和工艺,这属于硬技能,非大投入,不可成。

- 基础设施:数据的全面度和算法以及拥有多少算力,最终会变成,拼时间和算力。

- 模型PAAS:堡垒必然在模型服务的标准化上,同时重点的关注点一定是二次开发和私有化部署。

- 模型应用:跟业务走,有啥做啥,没啥技术竞争力,核心竞争力是业务理解能力。

不同企业一定需要在不同的层面找到自己的定位,比如而做软件服务商的,关注点必然是在模型工程化上,而自身就存在业务的,需要采纳模型的,那么一定要慎重的投入模型再训练,微调这些工作上面,没有价值,迟早被大模型企业给打掉。

未来怎么发展?

除了当下的逻辑外,大模型未来的发展是什么样的?首先开源大模型一定会是个玩具,仅可拿来做POC而已,这就意味着真正可稳定且高效运行的大模型服务,一定来自模型/平台厂商提供的模型服务。

- 目前很多企业觉得自己买一堆GPU放在自己的机房里,HF中把模型一拉,处理一些数据微调一下,似乎就能输出符合预期的结果了,于是自己私有化部署一套的方案似乎成为可行,实际上并不是。

- 大模型的定位,甚至在更广的层面,对它的定位是:新一代基础设施,怎么理解这个概念?简单来讲,当我们提到云上基础设施的时候,无论是说IAAS的云上虚拟的硬件,还是说PAAS级别的容器服务,一个单例服务都必须扛住万作单位的TPS和QPS,否则如何承载未来万物都构建在AI之上?其次还需要考虑模型推理的成本,那么大模型未来的发展的方向必然是:

- 小型化:只有小型化之后,才能降低硬件的需求,才可能降低成本,而小型化并不是卖点,但是会成为模型厂商的重点优化方向,一旦做好了这个事,就可以拥有更大的商务议价空间和更高的利润,就获得了更强的生存能力,甚至可以运行在远端,自然扩大了业务范围,也就实现了降维打击。

- 标准化:这里说的标准化,并不是只是模型本身,目前大家看到的模型,更像是一个操作系统内核,使用者需要自行构建用户态,而未来模型成为标品后,这些事情会打包起来,变成一个模块,比如微调就会变成一个标准的接口,根本不需要使用者感知。

而这些竞争力,并不会出现在开源市场,开源市场依旧会存在,且不停的放出一些阉割版的模型供大家娱乐,但是存在的价值,仅仅在于扩大影响力,吸引更多的人去了解这个领域,同时提供一个简陋版的模型,让你自己去POC,然后买更好的模型。

如何开始做?

如果你开始做一件事,发现全世界只有你在做,那么并不是你找到了一门独家生意,而是大概率这是个死胡同。

很多人开始做事的时候,总会看到前面有无数的人或者产品已经存在,于是会陷入疯狂卷功能,抄袭的阶段,因为担心推出太晚,最后没了市场,其实这种担心会过于过度,这个世界这么大,容得下所有人的生意。

扫码手机观看或分享: